Así es la primera ley que regula la inteligencia artificial

El Parlamento Europeo ha dado hoy luz verde a la Ley de Inteligencia Artificial (IA) con una amplia mayoría: 499 votos a favor, 28 en contra y 93 abstenciones. Comienzan ahora las negociaciones con los estados miembros para elaborar el texto definitivo, que previsiblemente entrará en vigor antes de 2026. La normativa nace con el objetivo de garantizar que la inteligencia artificial desarrollada y utilizada en Europa no vulnere derechos fundamentales.

La ley fija así una serie de obligaciones a los proveedores de herramientas basadas en inteligencia artificial, como la supervisión humana, la seguridad, la privacidad, la transparencia, la no discriminación o el bienestar social y medioambiental. Los límites varían en función del nivel de riesgo que la herramienta pueda presentar. En principio, quedan totalmente prohibidos los sistemas susceptibles de interferir en la seguridad de los usuarios, como aquellos que clasifican a partir del comportamiento o las características personales.

A esta limitación general los eurodiputados proponen sumar una serie de restricciones específicas, referidas a usos intrusivos y discriminatorios. De este modo, quedarían prohibidos:

- Los sistemas de identificación biométrica remota, en tiempo real o no, en espacios públicos.

- Los sistemas de categorización biométrica que utilicen ciertas características identitarias (por ejemplo, el género, la raza, la etnia, el estatus de ciudadanía, la religión o la orientación política).

- Los sistemas policiales predictivos (basados en la elaboración de perfiles, la ubicación o el historial delictivo).

- Los sistemas de reconocimiento de emociones por las fuerzas de seguridad en la gestión de fronteras, los lugares de trabajo o las instituciones de enseñanza.

- El rastreo indiscriminado de imágenes faciales sacadas de internet o de circuitos cerrados de televisión para crear bases de datos de reconocimiento facial (que violan el derecho a la intimidad).

También se consideran de alto riesgo –y quedan, por tanto, prohibidos– los sistemas que puedan influir de algún modo en los procesos electorales.

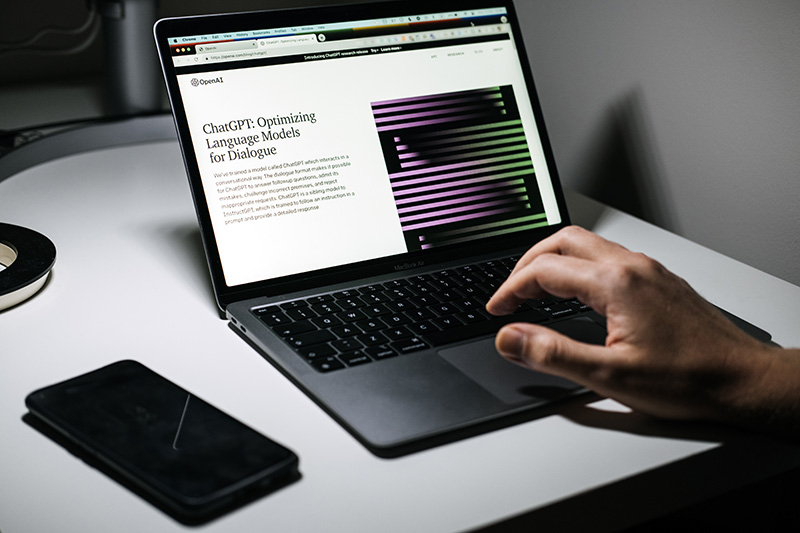

El texto aprobado ayer por la Eurocámara obliga a los proveedores de estos sistemas a registrar sus modelos en la base de datos de la UE antes de comercializarlos. Además, los sistemas de inteligencia artificial generativa, como ChatGPT, tendrán que cumplir unos requisitos adicionales de transparencia, como informar explícitamente que su contenido ha sido generado por IA. Se pretende así distinguir, por ejemplo, las falsificaciones de las imágenes auténticas. Igualmente deberán publicar resúmenes detallados de los datos protegidos por derechos de autor que han sido utilizados para su desarrollo.

Para impulsar la innovación y apoyar a las pymes, la ley hace una excepción con los proyectos de investigación y los componentes de IA suministrados con licencias de código abierto. Promueve, además, los llamados «espacios controlados de pruebas», entornos reales en los que las empresas pueden probar la inteligencia artificial bajo la supervisión de las autoridades públicas antes de salir al mercado.

El texto también contempla la posibilidad de que los ciudadanos puedan presentar alegaciones si consideran que sus derechos se han visto vulnerados por algún sistema de IA. En este sentido, se propone reformar la Oficina Europea de Inteligencia Artificial, que se encargaría de supervisar la forma en que se aplica el código normativo.

Desde esta organización censuran que «el Parlamento ha debilitado la clasificación de sistemas de alto riesgo al dar a los desarrolladores demasiada discreción para decidir si su sistema se considera de alto riesgo o no». Asimismo, lamentan que «los principios de transparencia y equidad son solo voluntarios, lo que limitará su utilidad». Además, advierten: «No se prohíbe el reconocimiento de emociones cuando se usa en las personas consumidoras, lo que puede conducir a graves intrusiones en la privacidad y afectar la capacidad de tomar decisiones autónomas».

[…] Ver en Twitter: https://twitter.com/Magisnet/status/1669010632778170371-Ir al artículo en https://www.magisnet.com/2023/06/…/ […]